どうもtttです。

もうタイトル通りですね。

ウェブマスターツールことサーチコンソールに「robots.txt取得エラー」が表示されるということは、サイト・ブログの死を意味するんです。

なんたって、ページのインデックスがドンドン削除されて行きますからね。洒落になりません。

で、なんと・・・

ここ数日、まさしく私が運営しているサイトの一部がそんな状況でした。

まぁ早い段階で気が付いたので、2~3日で順位も戻り、大きな被害にはならなかったのが不幸中の幸いですね。

と言うわけで、今後アナタが私と同じことにならないよう、「robots.txt取得エラー」のヤバさと、解決策についてシェアしたいと思います。

robots.txtって何?

robots.txtは、「ロボットに向けてのメッセージが書かれたテキスト」です。なんて言っても意味が全くわからないと思うので簡単に解説しておきます。

アナタが運営してるサイトやブログには、多かれ少なかれ毎日のように色んな人がアクセスしてくれてますよね?で、実はアクセスしてくれるのは"人"だけではなく、複数の"ロボット"もアクセスして来てるんです。これが通称、クローラーという奴ですね。

このクローラーの仕事は、web上のサイト情報を収集して自社データベースに持ち帰ることです。例えば、アナタが記事を更新するたびにインデックスされる・・・これは、googleクローラーのお陰ですね。

で、ここから超重要なんですが、アナタのサイトやブログが順位付けされてるのは、アナタのサイトやブログにgoogleクローラーがアクセスできるからなんです。逆から言えば、googleクローラーがアクセスできないと、評価はしてくれません。(評価できないともいう。)

もう気付いたかもしれませんけど、robots.txtってのは、こっちからロボットであるクローラーに意思表示できるんです。つまり、使い方によってはgoogleクローラーが入れなくすることだってできる。

『えっ?なんか重要っぽいけど、聞いたことすらないよ!?』と思うかもしれませんけど安心して頂きたい。普通にブログやサイトを運営する場合、robots.txtなんて使いませんからね。

【robots.txtを使っていない】=【制限無くアクセスしてOK】なんで、通常は全く問題ないんです。通常は・・・ね。

はい。というわけで、robots.txtの理解がプロレベルに深まった所で、次に進めたいと思います。

サイトのインデックス削除ラッシュが止まらない

冒頭でも伝えた通り、ここ数日、私が運営するサイトの一部は、インデックスが次々と削除されるという事態に陥ってました。

当日の衝撃は中々のレベルでしたね。いつも通りコーヒー飲みながらGRCでサイトの順位をチェックしたら、1位から圏外にぶっ飛んでるサイトがいくつかあるわけですから。モチロン、報酬も合わせてガタ落ちです。まさに地獄。

例えるなら、小5にもなって、授業中に先生のことを「お母さん」と呼んでしまうくらい地獄です。

こんな地獄すぎる状況でも『絶対に何か原因あるやろ!』と思いながら長時間探ってました。そしたらついに、サーチコンソール上でrobots.txtに問題があるとわかったんです。

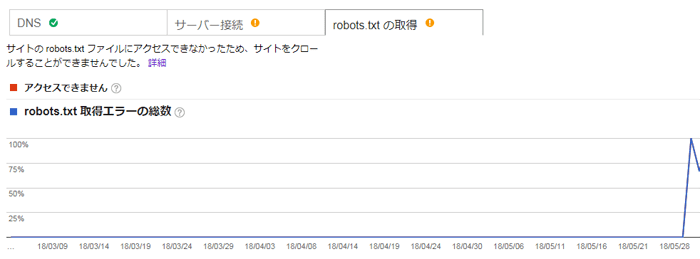

5/28から急にrobots.txt取得エラー

何の前触れもなく、いきなりこの有様です。『え!?急にどしたん!?』と。

『特にrobots.txtを弄ったわけでもない・・・というかrobots.txtすらない。んんん?サーバー側でなんかあった?』と思って調べてみると、予想的中。なんと私が契約してるサーバーが5/28辺りで新しいサーバーに切り替わってたんです。これを期に、通常robots.txtが無くても問題は無いのに、サーバー状況が不安定になったことでrobots.txt取得エラーが頻発してたというわけ。

状況を整理すると、インデックスが削除されまくってたサイト達は"全て同じサーバー"に入ってて、そのサーバーが"新しいサーバーに切り替わった"からgoogleクローラーが入れなくなってた←こういうことですね。

今回の事件を解決するために色々と調べて知ったんですが、米googleの偉い人いわく、『通常robots.txtはいらない。でもサーバーが不安定になった時はrobots.txtがないとrobots.txt取得エラーが出てしまう。だからrobots.txtは入れておいた方が安全だろう』とのこと。

つまり、事前に対策しておいた方がエエで!と米googleの偉い人は言ってるんです。

これ対策しておきたいやろ?ってことで、実際にtttが今回の事態を解決したrobots.txtを提供します。

是非、使ってください。

これをぶち込めば安心!!robots.txtをシェアします

私のように悲しい事態になりたくなければ、このrobots.txtをダウンロードして、アナタのサーバーにアップしておきましょう。

アップロード場所は、ドメイントップでOKです。

例えばこのサイトなら、「affiliate-blog7.com」と同じ階層にアップロードすればOKですね。

(サーバーによっては、「affiliate-blog7.com/public_html/」になります。)

ちなみに、このrobots.txtに書いてる内容は下記の2行だけです。

Disallow:

意味は、ザックリ言うと「制限なくアクセスしてOK!」ですね。

念のため言っておくと、「不正アクセスも大歓迎!!」みたいな話じゃないですよ。クローラーに対して、「このサイト・ブログにアクセス制限はございませんので、全てのページをご覧頂いて高評価してくだせぇ!!」って感じです。

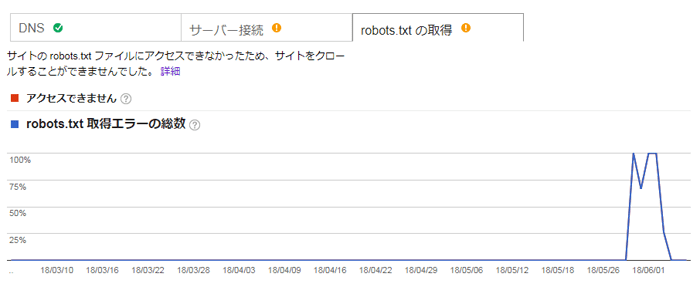

私は、このrobots.txtをぶち込んだことで、状況は落ち着きましたね。

robots.txt取得エラーはゼロになり、順位も回復しました

備えあれば憂いなし!ということで、是非アナタのサイトやブログにもぶち込んでおきましょう。

最後に

アフィリエイトに限らずですけど、自分でビジネスをやってたら未知の連続です。

時には問題を解決するために何日も掛かってしまうこともある。

ちなみに、私は今回の事態を解決するために、2日ぐらい費やしました。

でも『また、レベルアップできたなー』と思いましたね。

アナタも新しいことにチャレンジして何日も費やすことがあると思います。

でも、そこを乗り越えた人にしか成長はなく、成功もないということを知ってください。

諦めずに続けると・・・

テレレレー テッテッテーン!!

ずっとレベルを上げ続けたヤツは、ボロ勝ちしてまっせ。

ではまた。

メルマガ講座では、今まで鳴かず飛ばずだった方たちが結果を出せるようになった「9割の人ができていない"正しいアフィリエイトの取り組み方"」を語ってんで。

成功するために必須のプレゼントも渡してるから、しっかり学んでや。

当ブログで良く読まれている記事一覧はこちら

お世話になります。とろりです。

robots.txtってなんかたまに見るなー、くらいだったのですが、とても大切なものだったのですね!早速ダウンロードさせていただきました!

大変勉強になりました!ありがとうございます。

とろりさんどうも。

いやぁrobots.txtの重要性は半端じゃなかったです。

日々勉強ですね。

またどうぞ。

こんばんは

そんなに重要だとは知りませんでした。

私も、この後ダウンロードします。

良い情報ありがとうございました

また訪問します!

さちりんさんどうも。

是非ぶっこんでおいてください。

大事ですよ。

こんにちは。

いつも楽しく拝見させていただいています。

一瞬何事かと思いますね!!

私だったら、まったく分からず、へこんでるだけだったかも・・。

原因が分かってよかったですね!

情報ありがとうございます。

かなちんさんどうも。

一瞬所か、まぁまぁ長い時間『何事・・・?』状態でした。

それはさておき、ホント原因がわかってよかったです。

かなちんさんも是非対策を。

またどうぞ。

こんにちは。

robots.txtエラー恐ろしいですね。。

通常は要らないということですが、

サーバー環境でそうなってしまうのは盲点ですね。

ファイル有難うございます!

早速アップしようと思います。

マルーンさんどうも。

robots.txtエラーは中々の恐ろしさですよ。

知識は力ですね。

是非使ってください。

またどうぞ。

ロボットがアクセスって知って、え?ロボットってどういうこと?って思っちゃいました。

コンピューターの世界は不思議なことがたくさんありますね。

私はまだ被害にあった経験が無いのでよくわからないですが、いつ被害にあうか分からないんので事前にこういう情報をしてるのは嬉しいです!ありがとうございます。

yukoさんどうも。

良くわからない場合も、とりあえずぶち込んどけってことですね。

またどうぞ。

初めまして。

数日前に同じエラーが発生し、ヤバイ状況でした。

検査したらこの記事にたどり着き、robots.txtファイルとサイトのルート直下に置いたら、翌日無事に解消されました。

この方法がわからなければ大変なところでした。

この場を借りてお礼申し上げます。

ありがとうございました!

きたかぐらさんはじめまして。

おぉ・・・まさしく私と同じ状況だったみたいですね。

お役に立ったようで何よりです。

ついでに他の記事もお読みください(強制

またどうぞ。